Code

# !pip install dldna[colab] # in Colab

# !pip install dldna[all] # in your local

%load_ext autoreload

%autoreload 2“La percepción no es un fragmento de un solo sentido, sino una sinfonía en la que todos los sentidos se fusionan armónicamente.”, James Gibson, fundador de la ecopsicología.

Durante mucho tiempo en la historia de la inteligencia artificial, hubo un desafío difícil de resolver: el “multimodalidad”. Los humanos utilizamos simultáneamente varios sentidos (modalidades) como vista, audición y tacto para percibir el mundo, e integramos estos sentidos de manera orgánica. Por ejemplo, cuando bebemos café en un café, recibimos información diversa simultáneamente: el calor de la taza de café (tacto), el aroma del café (olfato), las conversaciones de las personas a nuestro alrededor (audición) y el paisaje interior del café (vista). A través de esta información, formamos una experiencia holística de estar en un café.

Sin embargo, los primeros modelos de inteligencia artificial tuvieron dificultades para procesar esta información multimodal. Las investigaciones en IA, que comenzaron a mediados de la década de 1950, se centraron principalmente en el procesamiento de una sola modalidad (texto, imagen, voz). Aunque hubo logros notables en cada campo, como traducción y reconocimiento de voz, integrar estos para comprender como lo hace un humano era un problema de otra dimensión.

En este capítulo, exploraremos a fondo las teorías fundamentales del aprendizaje profundo multimodal y las arquitecturas que han sobrevivido. Examinaremos cómo cada arquitectura ha extendido y evolucionado el ADN del aprendizaje profundo, y cómo contribuyen a resolver problemas complejos del mundo real.

Desafío: ¿Cómo integrar y procesar datos de diferentes formas, como texto, imagen y audio, en un solo modelo? Estos datos tienen formas de representación, dimensiones y características estadísticas diferentes. ¿Cómo fusionar información heterogénea para aprender una representación significativa?

Agonía del investigador: Los investigadores necesitaban encontrar nuevos métodos que pudieran modelar eficazmente la interacción entre las modalidades mientras mantenían sus características únicas, es decir, un nuevo ADN del aprendizaje profundo. Se requería una verdadera fusión más allá de una simple concatenación, donde cada modalidad comprendiera el contexto de las otras y proporcionara información complementaria.

Los datos multimodales se refieren a la combinación de dos o más formas diferentes de datos, como texto, imagen, audio y video. Por ejemplo, un artículo de noticias puede estar compuesto por texto e imágenes, mientras que una película está formada por video y audio. Los humanos integran naturalmente esta información multimodal; entender el entorno a través del tacto, oler y escuchar es algo completamente normal para nosotros.

¿Por qué el aprendizaje profundo multimodal fue un problema difícil?

Representación de datos heterogéneos: El texto, las imágenes y los audios tienen formas de representación, dimensiones y características estadísticas diferentes. Integrar y procesar eficazmente estos datos heterogéneos en un solo modelo ha sido un desafío.

Complejidad de la fusión de información: La simple concatenación de la información de cada modalidad no es una verdadera fusión. Se requiere modelar interacciones complejas, donde cada modalidad comprende el contexto de las otras, proporciona información complementaria y a veces armoniza información contradictoria.

Escasez e imbalance de datos: Los datos multimodales son relativamente escasos en comparación con los datos de una sola modalidad, y también existe un problema de desequilibrio entre las diferentes modalidades. Por ejemplo, hay más datos compuestos por imágenes y texto que datos que incluyen imágenes, texto y audio.

A pesar de estos desafíos, el aprendizaje profundo ha ofrecido nuevas posibilidades para el procesamiento de datos multimodales. Después de la década de 2010, el desarrollo de las tecnologías de aprendizaje profundo, especialmente la arquitectura del Transformer, jugó un papel decisivo en el avance del aprendizaje profundo multimodal. Esto fue un punto de inflexión crucial en el ADN del aprendizaje profundo. El mecanismo de autoatención (self-attention) del Transformer permitió modelar eficazmente no solo las relaciones entre los elementos dentro de cada modalidad, sino también las interacciones complejas entre diferentes modalidades. Hasta entonces, las CNN se habían especializado en el procesamiento de imágenes y las RNN en el procesamiento de datos secuenciales, mientras que el Transformer proporcionó una arquitectura versátil (universal) con la flexibilidad de aplicarse a diversas modalidades.

El aprendizaje profundo multimodal es una tecnología crucial para que la inteligencia artificial pueda entender e interactuar con el mundo como lo hace un ser humano. Va más allá de simplemente procesar diferentes formas de datos, conectando orgánicamente los significados contenidos en cada dato para permitir inferencias más ricas y precisas. Al igual que varias áreas del cerebro colaboran para realizar funciones cognitivas complejas, el aprendizaje profundo multimodal es una fuerza impulsora clave para elevar la inteligencia artificial a un nivel superior.

Áreas de aplicación principales

Respuesta a consultas visuales (Visual Question Answering, VQA): Genera respuestas a preguntas basadas en una imagen y una pregunta (texto). Va más allá del simple reconocimiento de objetos en la imagen, requiriendo una comprensión integral del significado de la imagen y la pregunta. Por ejemplo, para responder a “¿De qué color es el sombrero que lleva el hombre en la imagen?”, se necesita un proceso complejo que incluye encontrar al hombre, reconocer el sombrero y determinar su color.

Generación de descripciones de imágenes (Image Captioning): Genera automáticamente texto para describir una imagen. Requiere comprender con precisión el contenido de la imagen y expresarlo en oraciones naturales.

Análisis de sentimientos multimodal (Multimodal Sentiment Analysis): Determina los sentimientos del usuario combinando información como texto, voz y expresiones faciales. Puede detectar tonos irónicos o sutiles cambios emocionales a través de variaciones en el tono de voz o expresiones faciales que pueden ser difíciles de captar solo con texto.

Conducción autónoma: Integra datos de varios sensores, como cámaras (imágenes), LiDAR (sensores 3D), GPS (información de ubicación) y radares para reconocer el entorno circundante y tomar decisiones de conducción. Cada sensor proporciona información diferente, y su análisis integrado es necesario para una conducción precisa.

Manejo robótico: Para manipular objetos, un robot debe comprender la posición y forma del objeto visualmente y ajustar la fuerza adecuada basándose en la información táctil obtenida al agarrar el objeto.

Diagnóstico médico: Combina datos de diversas fuentes, como radiografías, MRI (imágenes), registros médicos (texto), señales biológicas (datos de series temporales) y información genética para diagnosticar y predecir enfermedades. Cada conjunto de datos proporciona pistas diferentes sobre la enfermedad, y su análisis integrado es esencial para un diagnóstico preciso.

La investigación en aprendizaje profundo multimodal es un viaje fascinante que muestra la evolución del ADN del aprendizaje profundo. Este viaje se puede dividir en las siguientes etapas principales.

A principios de la década de 2010, las investigaciones iniciales en aprendizaje profundo multimodal se centraron principalmente en la generación de descripciones de imágenes (image captioning) y VQA (Visual Question Answering). En esta época, los modelos basados en CNN-RNN predominaban, utilizando CNNs (Redes Neuronales Convolucionales) para extraer características de las imágenes y RNNs (Redes Neuronales Recurrentes) para procesar el texto. Las CNNs eran efectivas para capturar características espaciales en las imágenes, mientras que las RNNs eran fuertes en el procesamiento de información secuencial del texto. Sin embargo, los modelos iniciales solían utilizar principalmente el enfoque de fusión tardía (late fusion), que procesa cada modalidad de forma independiente y luego combina los resultados en la última etapa. Aunque este método tenía la ventaja de preservar las características únicas de cada modalidad, también tenía la limitación de no poder reflejar adecuadamente la interacción entre modalidades en las fases iniciales.

Entre los modelos representativos de esta época están DeViSE (Frome et al., 2013), que proyecta imágenes y embeddings de palabras en el mismo espacio para calcular la similitud entre imagen y texto, y m-RNN (Mao et al., 2014), que combina CNN y RNN para generar descripciones de imágenes y añade una capa multimodal para integrar información de diferentes modalidades.

A mediados de la década de 2010, la aparición del mecanismo de atención (attention mechanism) marcó un punto de inflexión importante en la investigación de deep learning multimodal. Este mecanismo permitió modelar más precisamente la relevancia entre imágenes y texto. Por ejemplo, en el caso de la generación de descripciones de imágenes, la atención permitía aprender qué regiones de la imagen “atender” al generar una palabra específica, y en VQA (Preguntas y Respuestas Visuales), ayudaba a determinar qué partes de la imagen observar para responder a una pregunta.

La introducción del mecanismo de atención mejoró significativamente el rendimiento de los modelos de generación de descripciones de imágenes y VQA. Algunos modelos representativos incluyen Show, Attend and Tell (Xu et al., 2015), que introduce la atención en la generación de descripciones de imágenes para centrarse en las regiones de la imagen relevantes a las palabras generadas, y Stacked Attention Networks (Yang et al., 2016), que aplica múltiples capas de atención a la imagen para generar respuestas a preguntas en VQA.

En 2017, con la introducción de la arquitectura del Transformer en el artículo “Attention is All You Need”, el deep learning multimodal entró en una nueva fase. El Transformer tiene la ventaja de poder modelar directamente las relaciones entre todos los elementos de una secuencia de entrada basándose en el mecanismo de autoatención (self-attention).

ViT (Vision Transformer, 2020): ViT divide las imágenes en parches (patches) y los introduce en un Transformer. ViT se convirtió en una alternativa potente a las CNN en el procesamiento de imágenes, mostrando un rendimiento excepcional en tareas como la clasificación de imágenes al modelar eficazmente las dependencias de largo alcance dentro de las imágenes.

CLIP (Contrastive Language-Image Pre-training, 2021): CLIP aprende a embeber imágenes y texto en el mismo espacio utilizando grandes conjuntos de datos de pares imagen-texto. Esto permitió lograr resultados revolucionarios en diversas tareas downstream, como la clasificación de imágenes y la detección de objetos, con un rendimiento sobresaliente sin necesidad de fine-tuning adicional.

DALL-E (2021), Imagen (2022), Stable Diffusion (2022): Los modelos que generan imágenes de alta calidad a partir de descripciones de texto demostraron las sorprendentes capacidades de los modelos generativos basados en Transformers. Estos modelos aprenden relaciones complejas entre texto e imágenes, produciendo resultados de generación de imágenes a un nivel que era difícil de imaginar anteriormente.

GPT-4V (2023), Gemini (2023): La aparición de modelos multimodales a gran escala (LMM, Large Multimodal Model) capaces de comprender y procesar texto e imágenes simultáneamente ha abierto nuevas posibilidades en el aprendizaje profundo multimodal. Estos enormes modelos con miles de millones de parámetros han logrado un rendimiento a nivel humano en diversas tareas multimodales, ubicándose en la vanguardia de la investigación de inteligencia artificial.

La investigación reciente en aprendizaje profundo multimodal ha evolucionado más allá de la simple fusión de información, hacia el desarrollo de la capacidad de generar e inferir nuevo conocimiento basándose en las diferentes modalidades.

Desarrollo del LMM (Large Multimodal Model): Están surgiendo continuamente LMMs que integran más modalidades (audio, video, datos de sensores 3D, etc.) y poseen habilidades de inferencia más complejas.

Investigación sobre técnicas eficientes de fusión: Por otro lado, también se está realizando una investigación activa en técnicas de fusión eficiente que maximicen el efecto de la integración de información mientras reducen los costos computacionales para utilizar eficazmente los modelos multimodales con recursos informáticos limitados.

Explicabilidad (XAI) y problemas éticos: A medida que aumenta la complejidad de los modelos multimodales, también crece la importancia de la investigación dirigida a comprender el proceso de toma de decisiones del modelo y abordar cuestiones éticas como sesgos.

En la siguiente sección examinaremos con más detalle los enfoques iniciales en el aprendizaje profundo multimodal, así como las principales arquitecturas que han “sobrevivido” durante este proceso.

Como se vio en la Sección 10.1.3, las transformer y CLIP han traído una innovación a la aprendizaje profundo multimodal. Sin embargo, este progreso no se logró de un día para otro. Antes de esto, ya existían numerosos intentos de combinar imágenes y texto, e incluso distintas modalidades, y estos estudios iniciales sentaron las bases sólidas del aprendizaje profundo multimodal moderno. En esta sección, examinaremos los enfoques clave y su significado que lideraron el amanecer de la investigación multimodal basada en aprendizaje profundo a principios y mediados de la década de 2010.

La generación de descripciones de imágenes (Image Captioning) es una tarea que consiste en generar automáticamente oraciones de lenguaje natural (descripciones) para describir una imagen dada. Esta es una problemática multimodal típica que convierte información visual (imágenes) en información lingüística (texto), y fue el principal objeto de estudio en los inicios de la investigación multimodal basada en aprendizaje profundo. La generación de descripciones de imágenes se asemeja a un niño que mira un libro de cuentos y dice: “¡Aquí hay un perro, y allá hay una pelota!”.

En los inicios de la investigación en generación de descripciones de imágenes, los modelos combinados de CNN y RNN predominaron. Era similar a conectar dos hemisferios cerebrales dentro del cerebro del aprendizaje profundo: un hemisferio visual gestionado por CNN y otro lingüístico gestionado por RNN. La CNN actuaba como codificador de imagen, utilizando redes como VGGNet o AlexNet para extraer vectores de características de la imagen, mientras que el RNN funcionaba como decodificador de texto, usando modelos como LSTM para generar oraciones de descripción basadas en los vectores de características de la imagen.

Un modelo representativo es Show and Tell (Vinyals et al., 2015), que propuso un método end-to-end que introduce las características de la imagen extraídas por CNN como el estado inicial oculto del LSTM para generar descripciones. Sin embargo, esta estructura CNN-RNN capturaba bien el contenido general de la imagen, pero tenía limitaciones en modelar claramente la relación entre áreas específicas de la imagen y palabras particulares del texto.

El mecanismo de atención, que “presta atención” a regiones específicas de la imagen, mejoró significativamente el rendimiento de los modelos de generación de descripciones de imágenes. El mecanismo de atención funciona similar a cómo nuestra vista naturalmente se dirige hacia las partes más importantes al apreciar una pintura.

Existen dos tipos principales de mecanismos de atención: Soft Attention y Hard Attention. Show, Attend and Tell (Xu et al., 2015) fue el primer modelo en introducir el mecanismo de Soft Attention a la generación de descripciones de imágenes, aprendiendo a qué región de la imagen prestar atención para generar cada palabra de la descripción, lo que permitió crear descripciones más precisas y detalladas.

A partir de 2017, surgió el enfoque Bottom-Up and Top-Down Attention, que combina información contextual general (top-down) con información sobre objetos individuales (bottom-up). El enfoque bottom-up utiliza modelos de detección de objetos como Faster R-CNN para identificar los objetos principales dentro de una imagen, mientras que el enfoque top-down calcula pesos de atención basados en estas características de objeto durante el proceso de generación de descripciones.

El modelo Bottom-Up and Top-Down Attention (Anderson et al., 2018) combinó ambos enfoques para mejorar significativamente el rendimiento en la generación de descripciones de imágenes. Esto es similar a considerar el flujo general de una historia mientras se describe detalladamente los objetos presentes en cada escena.

La investigación en captioning de imágenes ha añadido elementos importantes al ADN del aprendizaje profundo. La combinación CNN-RNN presentó un marco fundamental para combinar eficazmente diferentes modalidades, y el mecanismo de atención se consolidó como una tecnología clave en el aprendizaje multimodal profundo. Además, la Atención Bottom-Up and Top-Down elevó un paso más la capacidad de comprensión de imágenes de los modelos de aprendizaje profundo.

Estos avances no solo han impulsado el captioning de imágenes, sino que también sentaron las bases para su posterior expansión a diversas tareas multimodales, como VQA y traducción multimodal. Recientemente, han surgido modelos basados en transformadores, como BLIP, que están demostrando un buen rendimiento no solo en el captioning de imágenes, sino también en una variedad de tareas multimodales.

BLIP (Bootstrapping Language-Image Pre-training) es un modelo basado en transformadores para el captioning de imágenes. BLIP se pre-entrena conjuntamente con imágenes y texto, lo que permite un buen rendimiento no solo en el captioning de imágenes sino también en tareas multimodales como VQA y búsqueda de imagen-texto.

A continuación se muestra un ejemplo de código para generar captions de imágenes utilizando el modelo BLIP a través de la biblioteca Hugging Face Transformers.

# !pip install dldna[colab] # in Colab

# !pip install dldna[all] # in your local

%load_ext autoreload

%autoreload 2from transformers import BlipProcessor, BlipForConditionalGeneration

from PIL import Image

import requests

import matplotlib.pyplot as plt

# Load the model and processor

processor = BlipProcessor.from_pretrained("Salesforce/blip-image-captioning-base")

model = BlipForConditionalGeneration.from_pretrained("Salesforce/blip-image-captioning-base")

# Download the image

url = "http://images.cocodataset.org/val2017/000000000632.jpg"

image = Image.open(requests.get(url, stream=True).raw)

# Display the image

plt.imshow(image)

plt.axis('off')

plt.show()

# Preprocess the input

inputs = processor(image, return_tensors="pt")

# Generate the caption

outputs = model.generate(**inputs)

# Decode and print the caption

caption = processor.decode(outputs[0], skip_special_tokens=True)

print("Generated caption:", caption)

Generated caption: a bedroom with a bed and a windowPregunta y Respuesta Visual (Visual Question Answering, VQA) es una tarea en la que se proporciona una imagen y una pregunta formulada en lenguaje natural, y se genera una respuesta a dicha pregunta basándose en el contenido de la imagen. Si bien la generación de descripciones de imágenes consiste en “describir” el contenido de las imágenes, VQA implica hacer “preguntas y respuestas” sobre la imagen. Por ejemplo, responder a preguntas como “¿Qué está comiendo el gato?”. VQA requiere una comprensión más compleja y de mayor nivel de las imágenes en comparación con la generación de descripciones de imágenes, especialmente la capacidad de captar y razonar sobre la relación entre la imagen y la pregunta (texto).

Al igual que en la generación de descripciones de imágenes, los primeros modelos de VQA utilizaban una estructura combinada de CNN y RNN. Se extraían características de la imagen utilizando un CNN, se codificaba la pregunta con un RNN y luego se combinaban estas dos características para generar una respuesta. Sin embargo, simplemente combinar las características de la imagen y la pregunta no era suficiente para responder preguntas complejas.

Tras el éxito de los mecanismos de atención en la generación de descripciones de imágenes, estos fueron incorporados a VQA. El Co-Attention aplica atención tanto a la imagen como a la pregunta, calculando la relevancia entre cada palabra de la pregunta y cada región de la imagen. Esto permite encontrar de manera más precisa las regiones de la imagen relacionadas con la pregunta.

El Stacked Attention repite el proceso de atención varias veces para capturar gradualmente las relaciones complejas entre la imagen y la pregunta. Es como si un detective revisara una foto varias veces, profundizando gradualmente en su comprensión de la relación con la pregunta.

Entre los modelos representativos se encuentran Stacked Attention Networks (SAN) (Yang et al., 2016) y Dual Attention Networks (DAN) (Nam et al., 2017). SAN es un modelo que aplica múltiples capas de atención a la imagen para generar una respuesta a la pregunta, mientras que DAN calcula la atención por separado para la imagen y la pregunta, y luego combina estos resultados para generar la respuesta.

La mayor diferencia entre la generación de descripciones de imágenes y VQA es la integración de conocimiento externo. Para mejorar aún más las capacidades de inferencia de los modelos de VQA, se han realizado investigaciones para utilizar el conocimiento externo (conocimientos comunes, enciclopedias, etc.). El Knowledge Base (KB) utiliza bases de datos estructuradas como Wikipedia y ConceptNet para proporcionar la información necesaria para encontrar respuestas a las preguntas.

Las Redes de Memoria integran el conocimiento externo en forma de memoria, buscando y utilizando la información relevante de la memoria según la pregunta. Sin embargo, utilizar eficazmente el conocimiento externo sigue siendo un desafío importante debido a la incompletitud del conocimiento, la evaluación de la relevancia con respecto a la pregunta y la complejidad del proceso de inferencia.

La investigación en VQA ha añadido genes importantes al ADN del aprendizaje profundo. La combinación CNN-RNN proporciona una estructura básica para combinar imágenes y texto, compartida con la generación de descripciones de imágenes. El multimodal attention otorga a los modelos de aprendizaje profundo la capacidad de modelar relaciones complejas entre imagen y pregunta, lo que significa que estos modelos no solo combinan información, sino que también comprenden las interacciones entre diferentes tipos de información y pueden realizar inferencias.

La integración de conocimiento externo ha abierto la posibilidad de que los modelos de aprendizaje profundo realicen inferencias de mayor nivel utilizando el conocimiento y la experiencia humanos, en lugar de depender únicamente de los datos. 10.2.1 y 10.2.2 analizaron el captioning de imágenes y VQA, que fueron dos pilares fundamentales en las primeras investigaciones de aprendizaje profundo multimodal. Estos estudios contribuyeron significativamente a aplicar y desarrollar tecnologías clave del aprendizaje profundo como CNN, RNN y mecanismos de atención a problemas multimodales, y sentaron las bases para el surgimiento de modelos multimodales más potentes basados en transformadores (como CLIP, DALL-E, GPT-4V, Gemini, etc.).

Recientemente, han surgido modelos VQA basados en transformadores como ViLT (Vision-and-Language Transformer), que están demostrando un buen rendimiento. ViLT introduce parches de imagen y tokens de texto en el mismo modelo de transformador para modelar eficazmente las complejas interacciones entre imágenes y texto.

ViLT (Vision-and-Language Transformer) es uno de los modelos VQA basados en transformadores más destacados. ViLT introduce parches de imagen y tokens de texto en el mismo modelo de transformador para modelar eficazmente las complejas interacciones entre imágenes y texto.

A continuación se presenta un ejemplo de código para realizar VQA utilizando el modelo ViLT con la biblioteca Transformers de Hugging Face.

from transformers import ViltProcessor, ViltForQuestionAnswering

from PIL import Image

import requests

import matplotlib.pyplot as plt

# 모델과 프로세서 로드

processor = ViltProcessor.from_pretrained("dandelin/vilt-b32-finetuned-vqa")

model = ViltForQuestionAnswering.from_pretrained("dandelin/vilt-b32-finetuned-vqa")

# 이미지 다운로드

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

# 이미지 출력

plt.imshow(image)

plt.axis('off') # 축 제거

plt.show()

# 질문 설정

question = "How many cats are in the image?"

print("Question:", question)

# 입력 전처리

encoding = processor(image, question, return_tensors="pt")

# 추론

outputs = model(**encoding)

logits = outputs.logits

idx = logits.argmax(-1).item()

print("Predicted answer:", model.config.id2label[idx])

Question: How many cats are in the image?

Predicted answer: 2Supongamos que tenemos dos tipos de información: imágenes y texto. ¿Cómo podemos combinar esta información? El método más sencillo es agregar el vector de texto al final del vector de imagen para crear un nuevo vector. Este proceso de conectar información de fuentes de datos heterogéneas se denomina fusión (fusion). La capacidad de fusionar eficientemente la información de dos características de datos heterogéneas es fundamental en multimodalidad. Una de las razones por las que es difícil iniciar el aprendizaje profundo multimodal es porque es un campo que se está desarrollando muy rápidamente y carece de una sistematización adecuada.

En esta sección, nos basaremos en la clasificación propuesta en el curso de Multimodal Machine Learning de Carnegie Mellon University (CMU) para dividir la fusión multimodal en tres categorías principales. Aunque esta clasificación no es estándar en las investigaciones actuales de multimodalidad, es muy útil para entender sistemáticamente las diversas técnicas de fusión.

Las representaciones conjuntas son un método que representa los datos de múltiples modalidades en un espacio vectorial común (vector space). Es como si dibujáramos el texto y la imagen juntos en un solo lienzo.

En lugar de procesar los datos de cada modalidad por separado, se fusionan en un único vector de características integradas. Este vector encapsula la información de las modalidades. De esta manera, el modelo puede aprender las relaciones profundas entre las diferentes modalidades. Se puede manejar múltiples modalidades con un solo modelo. Además, al comprimir la información de varias modalidades en un solo vector, la estructura del modelo es relativamente simple y eficiente. Sin embargo, las características únicas de cada modalidad pueden diluirse o perderse durante el proceso de fusión. Si una modalidad contiene significativamente más información que otra, puede surgir un problema de desequilibrio de información. Y fusionar los datos de diferentes modalidades en un vector significativo es un problema muy difícil.

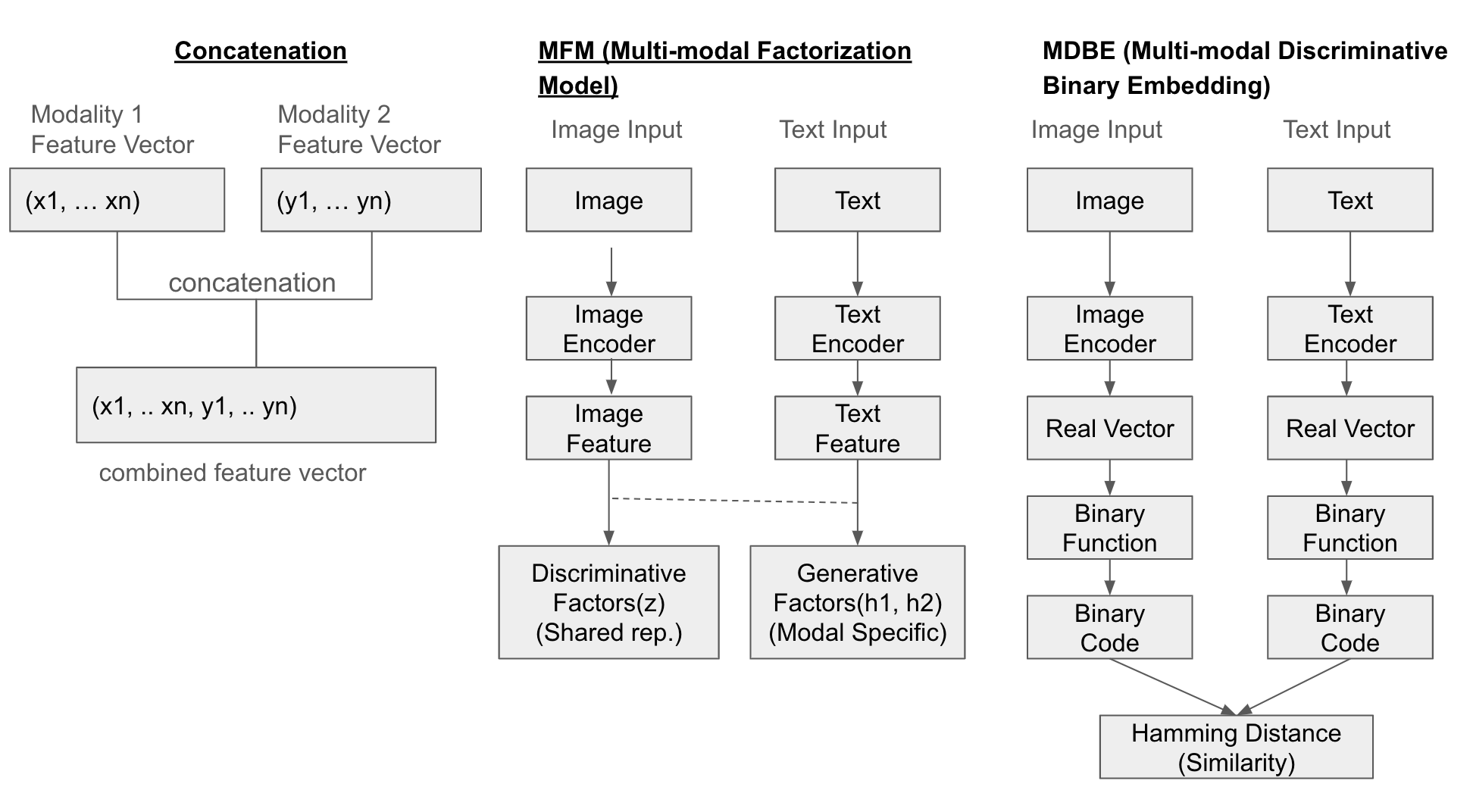

El método más simple es concatenar (concatenate) los vectores de características de cada modalidad. Además, el Modelo de Factorización Multimodal (Multi-modal Factorization Model, MFM) combina múltiples conjuntos de datos a través de la factorización matricial para crear un espacio de representación común. El Embebido Binario Discriminativo Multimodal (Multi-modal Discriminative Binary Embedding, MDBE) es un método que representa los datos multimodales como códigos binarios.

En investigaciones recientes, se han propuesto métodos como COSA (Concatenated Sample), que conecta secuencialmente múltiples pares imagen-texto y aplica modelos basados en transformers para aprender conjuntamente el contenido visual y las pistas temporales. Además, la Concatenación Atencional es un método para generar imágenes de alta resolución a partir del texto, utilizando una estructura en cascada de múltiples niveles y empleando los resultados de capas anteriores junto con vectores de palabras como entrada para capas posteriores.

Ejemplo de estructura

A continuación se muestra la ilustración de tres métodos de fusión (Concatenation, MFM, MDBF).

Ejemplo

from transformers import AutoModel, AutoProcessor, AutoTokenizer

from PIL import Image

import torch

import requests

import matplotlib.pyplot as plt

# Load pre-trained models and processor/tokenizer for image and text

image_model_name = "google/vit-base-patch16-224-in21k" # ViT (Vision Transformer)

text_model_name = "bert-base-uncased" # BERT

image_processor = AutoProcessor.from_pretrained(image_model_name)

image_model = AutoModel.from_pretrained(image_model_name)

tokenizer = AutoTokenizer.from_pretrained(text_model_name)

text_model = AutoModel.from_pretrained(text_model_name)

# Example image and text

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

text = "Two cats sleeping on a couch."

# Display the image

plt.imshow(image)

plt.axis('off') # Remove axes

plt.show()

# Preprocess image and text

image_inputs = image_processor(images=image, return_tensors="pt")

text_inputs = tokenizer(text, return_tensors="pt")

# Feature extraction (embeddings) for each modality

with torch.no_grad(): # Disable gradient calculation (inference mode)

image_features = image_model(**image_inputs).last_hidden_state[:, 0, :] # [CLS] token embedding

text_features = text_model(**text_inputs).last_hidden_state[:, 0, :] # [CLS] token embedding

# Create Joint Representation (Concatenation)

joint_representation = torch.cat((image_features, text_features), dim=1)

print("Image Features Shape:", image_features.shape) # Image feature vector size

print("Text Features Shape:", text_features.shape) # Text feature vector size

print("Joint Representation Shape:", joint_representation.shape) # Combined feature vector size (image + text)Fast image processor class <class 'transformers.models.vit.image_processing_vit_fast.ViTImageProcessorFast'> is available for this model. Using slow image processor class. To use the fast image processor class set `use_fast=True`.

Image Features Shape: torch.Size([1, 768])

Text Features Shape: torch.Size([1, 768])

Joint Representation Shape: torch.Size([1, 1536])Las Representaciones Coordinadas son un enfoque que representa cada modalidad en espacios separados, pero aprende explícitamente las relaciones entre ellos. Es similar a tener varios dibujos en diferentes lienzos, asegurando que cada lienzo se armonice con los demás.

Cada modalidad se representa mediante vectores de características distintos, pero estos vectores son entrenados para “coordinarse” entre sí. Esto significa que, aunque los espacios de características de cada modalidad sean independientes, aprenden las similitudes, relaciones de orden, etc., para establecer relaciones significativas entre ellos. La ventaja de este enfoque es que puede preservar al máximo las características únicas de cada modalidad, mientras considera la relevancia con otras modalidades. Además, permite aprender diversas formas de relaciones entre modalidades, lo que lo hace aplicable a una amplia gama de problemas multimodales.

Sin embargo, dado que cada modalidad se procesa por separado, la estructura del modelo puede ser más compleja en comparación con las Representaciones Conjuntas. Esto puede dificultar el diseño y entrenamiento del modelo. Además, aprender explícitamente las relaciones entre modalidades es un desafío.

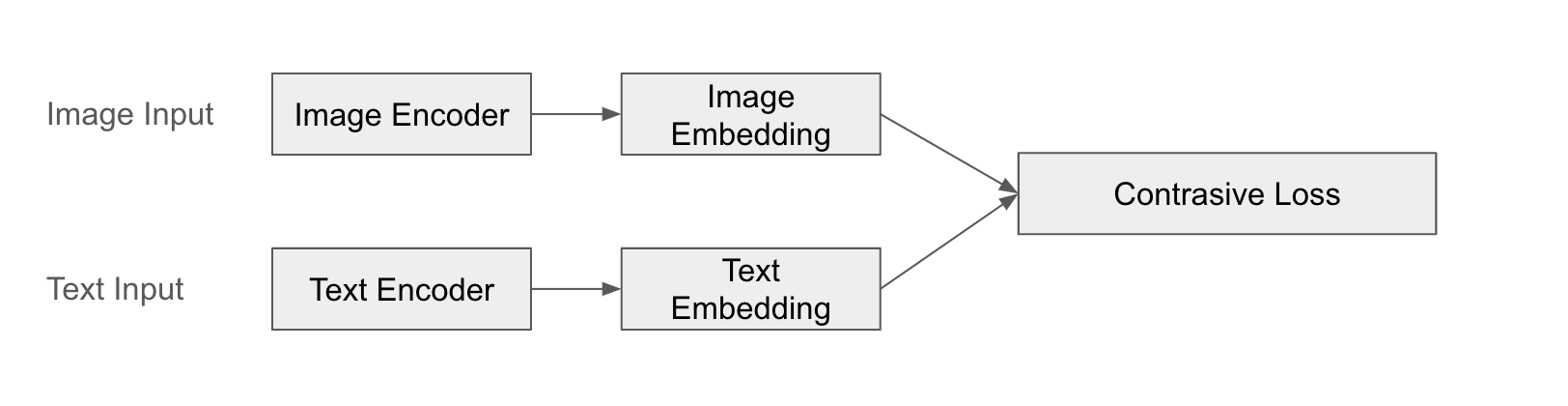

Un ejemplo destacado es CLIP (Contrastive Language-Image Pre-training). CLIP procesa imágenes y texto mediante codificadores separados para obtener vectores de características y luego aprende la similitud entre ellos. CLIP se entrena para que las imágenes y el texto sean “parejas” entre sí, estableciendo relaciones significativas entre imagen y texto.

El éxito de CLIP es particularmente notable en su capacidad de aprendizaje zero-shot. El modelo pre-entrenado de CLIP puede clasificar o buscar nuevas imágenes sin necesidad de entrenamiento adicional para una tarea específica. Esto es posible debido a la efectiva aprendizaje de conexiones semánticas entre texto e imagen.

Ejemplo de estructura

A continuación se muestra una ilustración de la fusión en CLIP.

Ejemplo

from transformers import CLIPProcessor, CLIPModel

from PIL import Image

import torch

import requests

import matplotlib.pyplot as plt

# Load CLIP model and processor

model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32")

processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32")

# Example image and text

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

text = "Two cats sleeping on a couch."

# Display image

plt.imshow(image)

plt.axis('off') # Remove axes

plt.show()

# Preprocess image and text

inputs = processor(text=[text], images=image, return_tensors="pt", padding=True)

# Extract image and text features (embeddings)

with torch.no_grad():

outputs = model(**inputs)

image_features = outputs.image_embeds

text_features = outputs.text_embeds

# Coordinated Representation: Keep features of each modality separate

print("Image Features Shape:", image_features.shape)

print("Text Features Shape:", text_features.shape)

# Calculate similarity between image and text (dot product)

similarity = torch.matmul(image_features, text_features.T) # Or text_features @ image_features.T

print("Image-Text Similarity:", similarity.item())

Image Features Shape: torch.Size([1, 512])

Text Features Shape: torch.Size([1, 512])

Image-Text Similarity: 0.29803216457366943Aplicando el método anterior, es posible realizar una prueba de zero-shot de la siguiente manera.

# Zero-shot 이미지 분류

# - 여러 텍스트 후보군을 만들고, 각 텍스트와 이미지 간의 유사도를 계산하여 가장 높은 유사도를 갖는 텍스트를 선택

candidate_texts = ["a photo of a cat", "a photo of a dog", "a photo of a bird"]

inputs = processor(text=candidate_texts, images=image, return_tensors="pt", padding=True)

with torch.no_grad():

outputs = model(**inputs)

image_features = outputs.image_embeds

text_features = outputs.text_embeds

logits_per_image = outputs.logits_per_image # 유사도 점수

probs = logits_per_image.softmax(dim=1) # 확률

predicted_class_idx = probs.argmax().item()

predicted_class = candidate_texts[predicted_class_idx]

print("Predicted Class:", predicted_class)

print("Probabilities:", probs)Predicted Class: a photo of a cat

Probabilities: tensor([[9.9403e-01, 5.1377e-03, 8.3070e-04]])El codificador-decodificador es un método que convierte datos de una modalidad en datos de otra modalidad. Es una técnica comúnmente utilizada en la traducción de lenguajes.

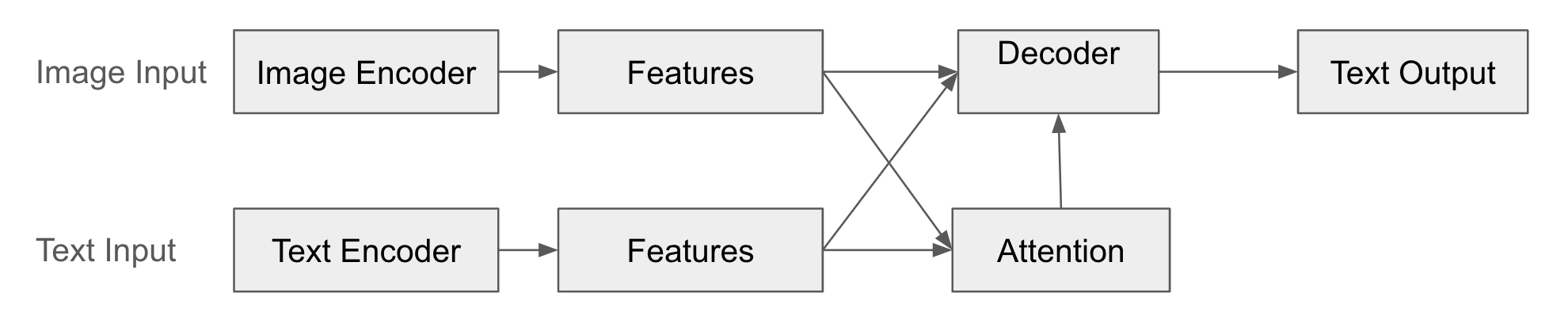

En esta estructura, el codificador (Encoder) convierte los datos de la modalidad de entrada (por ejemplo, imágenes) en vectores de características. Este vector de características representa de manera concisa la información clave de los datos de entrada. El decodificador (Decoder) genera datos de otra modalidad (por ejemplo, texto) basándose en el vector de características creado por el codificador. El decodificador “interpreta” la salida del codificador para generar un nuevo tipo de datos. Además, mediante el mecanismo de atención, el decodificador aprende a qué partes del vector de características del codificador debe “prestar atención” al generar los datos de salida.

Una ventaja de este enfoque es que se puede aplicar a diversas tareas que conectan formas diferentes de datos, como la generación de descripciones para imágenes, P+R visual (Pregunta-Respuesta Visual), y traducción automática. Además, es aplicable incluso cuando las modalidades de entrada y salida son diferentes, permitiendo combinaciones variadas como texto-imagen, imagen-texto, audio-texto, etc.

Un ejemplo destacado es la generación de descripciones para imágenes y P+R visual (Pregunta-Respuesta Visual). En la generación de descripciones para imágenes, se procesa la imagen con el codificador para obtener un vector de características, y luego se utiliza el decodificador para generar una descripción (texto). En P+R visual, se procesan tanto la imagen como la pregunta (texto) con sus respectivos codificadores, y se utiliza un mecanismo de atención para determinar la relevancia entre la imagen y la pregunta antes de usar el decodificador para generar una respuesta (texto).

Sin embargo, si los datos de entrada o salida son largos, puede ocurrir pérdida de información o aumento en la cantidad de cálculos. En particular, en modelos basados en RNN, el problema de desaparición del gradiente (gradient vanishing problem) puede dificultar el aprendizaje de dependencias a largo plazo. Además, al tener que aprender tanto el codificador como el decodificador simultáneamente, el proceso de entrenamiento puede ser inestable o difícil.

Ejemplo de estructura

Lo siguiente es una representación diagramática de la fusión de codificador-decodificador.

from transformers import BlipProcessor, BlipForConditionalGeneration

from PIL import Image

import requests

import matplotlib.pyplot as plt

# Load model and processor

processor = BlipProcessor.from_pretrained("Salesforce/blip-image-captioning-base")

model = BlipForConditionalGeneration.from_pretrained("Salesforce/blip-image-captioning-base")

# Download image

url = "http://images.cocodataset.org/val2017/000000000139.jpg"

image = Image.open(requests.get(url, stream=True).raw)

# Display image

plt.imshow(image)

plt.axis('off')

plt.show()

# Input text (optional - Conditional Generation)

# text = "describe this image:" # Prompt (guide image description)

text = "a photo of"

# Preprocess image and text (optional)

# If text is provided, it uses the text as a prompt to generate the caption.

inputs = processor(image, text=text, return_tensors="pt")

# Generate caption

outputs = model.generate(**inputs)

# Decode and print caption

caption = processor.decode(outputs[0], skip_special_tokens=True)

print("Generated caption:", caption)

Generated caption: a photo of a living room with a television and a fireplaceEste ejemplo muestra la imagen captioning, que es un caso típico de la estructura Encoder-Decoder. El codificador recibe una imagen (el codificador visual de BLIP) y extrae un vector de características. El decodificador genera texto (el decodificador de texto de BLIP). A través del mecanismo de atención, se decide a qué partes del vector de características de la imagen prestar atención mientras se genera el caption. Se pueden especificar prompts que influyen en el caption generado como texto. Aunque BLIP puede utilizar tanto imágenes como texto como entrada, aquí solo se usa una imagen como entrada y el texto se genera en el decodificador.

En las secciones 10.3.1, 10.3.2, 10.3.3 se han examinado las tres teorías clave de la fusión multimodal: Joint Representations, Coordinated Representations, Encoder-Decoder. Cada enfoque tiene sus propias características y ventajas y desventajas, por lo que es importante seleccionar el método adecuado según el campo de aplicación.

La “fusión” en el aprendizaje profundo multimodal es un proceso clave que combina información de diferentes modalidades para crear representaciones más ricas y poderosas. Aunque en la sección 10.3 revisamos brevemente la teoría de fusión basada en las lecciones de CMU, la investigación real sobre fusión multimodal ha evolucionado de manera mucho más diversa y dinámica. En este análisis detallado, examinaremos varios sistemas de clasificación de la fusión y tendencias de investigación recientes, así como las tecnologías que están ganando atención en 2025.

La fusión multimodal es difícil de clasificar con un solo criterio. Los investigadores han categorizado los métodos de fusión desde diferentes perspectivas, y cada clasificación no es mutuamente excluyente sino complementaria.

Esta clasificación se centra en la “etapa” del modelo de aprendizaje profundo multimodal donde ocurre la fusión. (Ver sección 10.3.4 del texto)

Early Fusion (Fusión Temprana): Combina los datos “crudos” (o características procesadas muy temprano) de cada modalidad en la etapa de entrada del modelo.

Late Fusion (Fusión Tardía): Procesa cada modalidad con modelos separados y combina las salidas de los modelos (por ejemplo, resultados de predicción) en la última etapa.

Hybrid Fusion (Fusión Híbrida): Combina los métodos de fusión temprana y tardía. Realiza la fusión en múltiples etapas del modelo para aprovechar información a diferentes niveles.

Fusión Model-Agnostic: Técnicas de fusión generales que no dependen de un modelo específico (Early, Late, Hybrid Fusion, etc.).

Fusión Model-Specific: Técnicas de fusión especializadas para estructuras de modelos específicas.

Investigación más reciente: En el taller CVPR (MULA 2025) programado para los días 11-12 de junio de 2025, se discutirán investigaciones sobre estructuras de modelos para fusionar eficazmente diversos datos sensoriales (cámara, LiDAR, radar, etc.) en el campo de la conducción autónoma. Este taller tiene como objetivo fomentar la interacción y colaboración interdisciplinaria entre las comunidades de visión por computadora, multimedia, teledetección y robótica, con un enfoque particular en los enfoques multimodales para la conducción autónoma.

Fusión simétrica vs. asimétrica:

Simétrica: Trata todos los modos de manera igual.

Asimétrica: Da más peso a ciertos modos o les asigna diferentes roles.

Investigación reciente: “Learning Deep Multimodal Feature Representation with Asymmetric Multi-layer Fusion” propuso un marco efectivo para fusionar características multimodales en múltiples capas dentro de una sola red. Esta investigación introduce dos operaciones de fusión asimétrica, shuffle de canales y shift de píxeles, que aprenden diferentes características según las direcciones de fusión. Además, “Multimodal sentiment analysis based on multi-layer feature fusion” presentado en enero de 2025 propuso un nuevo enfoque para el análisis preciso del sentimiento en condiciones de desequilibrio modal e implicaciones implícitas.

Fusión explícita vs. implícita:

Explícita: Define o modela explícitamente las relaciones entre los modos. (Ejemplo: mecanismos de atención)

Implícita: No define directamente las relaciones entre los modos, sino que permite que el modelo aprenda estas relaciones por sí mismo. (Ejemplo: combinación simple)

Investigación reciente: Se espera que en la Conferencia HCI International 2025 (junio de 2025) se presente una investigación comparando las ventajas y desventajas de la fusión explícita y la fusión implícita.

El mecanismo de fusión basada en atención es el enfoque más destacado en las investigaciones de 2024-2025.

Concepto: Se utiliza una característica de un modo como consulta (query) para aplicar la atención a otra característica (key-value) del otro modo. (Ver sección 10.4.2) De esta manera, el modelo puede comprender con precisión qué elementos específicos de un modo están relacionados con los elementos de otro.

Investigación reciente

En enero de 2025, “Bi-Att3DDet” presentó un método de fusión basada en atención bidireccional para la detección de objetos 3D en conducción autónoma. Esta investigación propone una interacción bidireccional para maximizar la información complementaria entre los datos de LiDAR y cámara.

“LANMSFF” presentado en marzo de 2024 y revisado en febrero de 2025, combinó una red neuronal basada en atención ligera con fusión de características multiscale para el reconocimiento de expresiones faciales multi-vista. Este enfoque genera mapas de atención canal y espacial simultáneamente para destacar características importantes e inhibir las irrelevantes.

Recientes investigaciones neurocientíficas (2025) han examinado el impacto de la congruencia cruzada modal (cross-modal congruency) en el procesamiento y acumulación de información sensorial. Estos estudios demostraron que la congruencia entre estímulos auditivos y visuales desempeña un papel crucial en las etapas iniciales del procesamiento sensorial. #### 2.2 Atención Multi-cabeza

Concepto: Se utilizan múltiples cabezas de atención para capturar las relaciones entre modalidades desde diferentes perspectivas. Cada cabeza utiliza matrices de pesos diferentes (W_Q, W_K, W_V) para transformar los datos de entrada y calcular la atención, por lo que cada cabeza puede concentrarse en diferentes aspectos de los datos de entrada (por ejemplo, significado, estructura gramatical, estilo).

Ventajas: Puede modelar diferentes tipos de relaciones simultáneamente, lo que permite aprender representaciones más ricas y complejas. Por ejemplo, al fusionar imágenes y texto, algunas cabezas pueden concentrarse en las relaciones entre los objetos en la imagen y las palabras en el texto, mientras que otras cabezas pueden centrarse en las relaciones entre la atmósfera general de la imagen y el tono del texto.

Investigación reciente: Los modelos multimodales a gran escala (LMM) han ampliado y refinado esta técnica para modelar eficazmente interacciones complejas entre diferentes modalidades, como imágenes, texto, audio y video.

Aprendizaje contrastivo (Contrastive Learning):

Concepto: Se aprende a posicionar pares de modalidades relacionadas (por ejemplo, una imagen y su leyenda correspondiente) cerca en el espacio de embeddings, mientras que los pares no relacionados se posicionan lejos.

Ventajas: Permite aprender eficazmente incluso con grandes conjuntos de datos sin etiquetas, lo que ayuda a resolver problemas de escasez de datos.

Investigación reciente: “Dual-Level Cross-Modal Contrastive Clustering” (2024) propone un nuevo método de aprendizaje contrastivo para cerrar la brecha entre las representaciones visuales y los significados del texto.

Aprendizaje basado en máscaras (Masking-based Learning):

Concepto: Se aprende a reconstruir una parte de la entrada que ha sido enmascarada utilizando información de otra modalidad.

Ventajas: Permite aprender relaciones complementarias entre modalidades. Por ejemplo, se puede aprender a predecir partes ocultas de una imagen usando descripciones de texto o a predecir palabras ocultas en un texto usando una imagen.

Investigación reciente: CAST (2025) mejoró el alineamiento entre nodos de estructuras gráficas y tokens de texto mediante la estrategia de preentrenamiento Masked Node Prediction (MNP).

Fusión a nivel de token (Token-level Fusion): Modela las interacciones detalladas entre tokens individuales de cada modalidad (por ejemplo, parches de imagen, tokens de texto).

Ventajas: Permite capturar relaciones más precisas entre modalidades. Por ejemplo, puede aprender la relación directa entre un objeto específico en una imagen y una palabra específica en el texto.

Investigación reciente: CAST (2025) demostró que la fusión a nivel de token entre nodos gráficos y tokens de texto en ciencias de materiales es superior a la fusión a nivel de instancia.

Fusión a nivel de instancia (Instance-level Fusion): Trata las instancias completas de cada modalidad (por ejemplo, una imagen completa, un texto completo) como una única unidad para su fusión.

Ventajas: Es computacionalmente eficiente y fácil de implementar.

Desventajas: Puede no capturar relaciones detalladas dentro de las modalidades.

La fusión multimodal puede clasificarse de diversas formas, y cada forma de clasificación ofrece una perspectiva diferente. En la investigación práctica, es común combinar estas clasificaciones para aprovechar sus fortalezas. En 2025, la investigación de fusión multimodal se centra en el desarrollo de técnicas eficientes de fusión utilizando interacciones detalladas a nivel de token, mecanismos de atención cruzada y métodos de aprendizaje autónomo. En particular, eventos académicos importantes como el taller CVPR 2025 (junio del 25, Nashville) discutirán activamente el progreso de las tecnologías de fusión multimodal en diversos campos de aplicación, como conducción autónoma, diagnóstico médico y ciencia de materiales.

A través de este profundización, se espera comprender diversas clasificaciones de la fusión multimodal y analizar más a fondo los distintos modelos multimodales que se presentarán.

Ingrese el texto en coreano aquí.

De las secciones 10.3.1 a 10.3.3, hemos examinado los métodos para fusionar datos multimodales. Esta es una clasificación teórica. Al diseñar un modelo multimodal real, es necesario decidir estratégicamente qué método de fusión, en qué punto y cómo aplicarlo según las características del problema y los datos dados. En esta sección, examinaremos las estrategias sofisticadas de integración modal adoptadas por los modelos multimodales más recientes.

La fusión temprana combina las entradas de múltiples modalidades en una etapa inicial del modelo. La forma más simple es concatenar los vectores de características de cada modalidad. La ventaja de la fusión temprana es que facilita capturar interacciones de bajo nivel (low-level) entre modalidades. Por ejemplo, si el color de una imagen y ciertas palabras en un texto están fuertemente relacionadas, la fusión temprana puede facilitar el aprendizaje de estas relaciones. Sin embargo, tiene la desventaja de que puede no aprovechar adecuadamente las características de cada modalidad. Especialmente cuando se requiere procesamiento especializado para cada modalidad (por ejemplo, CNN para imágenes, RNN para texto), la fusión temprana puede ser ineficiente.

Las investigaciones recientes también han presentado benchmarks que evalúan el rendimiento de la fusión temprana en entornos de datos multimodales ruidosos (noisy data) y con alta incertidumbre, además del simple concatenamiento.

Veamos un ejemplo sencillo de fusión temprana. Aquí usamos concatenación para realizar una representación conjunta. Se utiliza el mismo código. Al final, se aplica un clasificador lineal simple para determinar si hay un gato o no.

from transformers import AutoModel, AutoProcessor, AutoTokenizer

from PIL import Image

import torch

import requests

import matplotlib.pyplot as plt

# 이미지와 텍스트를 위한 사전 학습된 모델 및 프로세서/토크나이저 로드

image_model_name = "google/vit-base-patch16-224-in21k" # ViT (Vision Transformer)

text_model_name = "bert-base-uncased" # BERT

image_processor = AutoProcessor.from_pretrained(image_model_name)

image_model = AutoModel.from_pretrained(image_model_name)

tokenizer = AutoTokenizer.from_pretrained(text_model_name)

text_model = AutoModel.from_pretrained(text_model_name)

# 예제 이미지 및 텍스트

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

text = "Two cats sleeping on a couch."

# 이미지 출력

plt.imshow(image)

plt.axis('off') # 축 제거

plt.show()

# 이미지와 텍스트 전처리

image_inputs = image_processor(images=image, return_tensors="pt")

text_inputs = tokenizer(text, return_tensors="pt")

# 각 모달리티에 대한 특징 추출 (임베딩)

with torch.no_grad(): # 기울기 계산 비활성화 (추론 모드)

image_features = image_model(**image_inputs).last_hidden_state[:, 0, :] # [CLS] 토큰 임베딩

text_features = text_model(**text_inputs).last_hidden_state[:, 0, :] # [CLS] 토큰 임베딩

# Joint Representation 생성 (Concatenation)

joint_representation = torch.cat((image_features, text_features), dim=1)

print("Image Features Shape:", image_features.shape) # 이미지 특징 벡터 크기

print("Text Features Shape:", text_features.shape) # 텍스트 특징 벡터 크기

print("Joint Representation Shape:", joint_representation.shape) # 결합된 특징 벡터 크기 (image + text)

# Joint Representation을 활용한 추가 작업 (예: 분류)

num_labels = 2 # 예: "고양이 없음(0)" "고양이 있음(1)", 두 가지 클래스로 분류

classifier = torch.nn.Linear(joint_representation.size(1), num_labels) # 간단한 선형 분류기

outputs = classifier(joint_representation)

print("Classification Outputs:", outputs)Fast image processor class <class 'transformers.models.vit.image_processing_vit_fast.ViTImageProcessorFast'> is available for this model. Using slow image processor class. To use the fast image processor class set `use_fast=True`.

Image Features Shape: torch.Size([1, 768])

Text Features Shape: torch.Size([1, 768])

Joint Representation Shape: torch.Size([1, 1536])

Classification Outputs: tensor([[0.1817, 0.0355]], grad_fn=<AddmmBackward0>)En el ejemplo anterior, las imágenes y el texto se combinan directamente con la salida de modelos separados denominados ViT y BERT, respectivamente. No se realiza un procesamiento adicional (atención, transformaciones complejas, etc.) en estos dos vectores antes de combinar las características de imagen y texto. Por lo tanto, esto corresponde a una fusión temprana.

La fusión tardía implica procesar cada modalidad con modelos separados y combinar la salida de cada modelo (por ejemplo, los resultados de predicción) en la última etapa. La ventaja de este método es que se pueden usar modelos especializados para cada modalidad. Por ejemplo, se puede utilizar una CNN pre-entrenada para imágenes y un Transformer pre-entrenado para texto, lo que permite extraer eficazmente características complejas de cada modalidad. Sin embargo, esta técnica solo considera interacciones de alto nivel entre las modalidades, lo que dificulta el intercambio de información en etapas intermedias.

La fusión tardía se ha estudiado activamente para combinar la salida de modelos de diferentes modalidades y mejorar el rendimiento, similar a las técnicas de ensemble.

La fusión híbrida es una combinación de Early Fusion y Late Fusion. Se realiza la fusión en múltiples etapas del modelo para aprovechar información a diferentes niveles. La ventaja de este método es que puede incorporar las ventajas tanto de Early Fusion como de Late Fusion, es decir, considerar interacciones de bajo nivel y alto nivel entre modalidades. Sin embargo, esto también conlleva una mayor complejidad en la estructura del modelo y un aumento en el número de hiperparámetros a ajustar.

Un ejemplo representativo de fusión híbrida es la Cross-Modal Attention, que implica aplicar atención a las características de una modalidad (key-value) utilizando las características de otra modalidad como consulta (query). Este método es típico para realizar la fusión en etapas intermedias.

En investigaciones recientes, además de la atención, se han explorado otras técnicas como mecanismos con puertas y pooling bilineal para realizar fusiones en etapas intermedias.

Desde 2023, modelos multimodales a gran escala (LMM) como Gemini y GPT-4V han implementado estrategias de integración de modalidades más sofisticadas para mejorar significativamente el rendimiento.

El mecanismo de fusión selectiva (Selective Fusion Mechanism) evalúa dinámicamente la importancia de cada modalidad y combina la información de manera selectiva. Por ejemplo, si una imagen contiene texto, se fortalece la asociación entre las características visuales del área de texto y el contenido del texto. Esto es similar a cómo las personas ajustan la importancia de la información visual y textual según las necesidades específicas.

El ajuste automático de contribución (Task-Specific Fusion) optimiza la forma de integrar modalidades según los requisitos de tareas específicas. En el caso del captioning de imágenes, se enfatiza en la transformación unidireccional de información visual a texto, mientras que en las respuestas visuales a preguntas, se refuerza la interacción bidireccional.

Estas estrategias sofisticadas de integración han mejorado significativamente el rendimiento de los modelos multimodales. En particular, al ir más allá de la simple combinación de información y ajustar dinámicamente el rol e importancia de cada modalidad, así como optimizar la fusión según las características de la tarea, estos modelos han demostrado excelentes resultados en tareas que requieren inferencias complejas. Estas estrategias de integración requieren conjuntos de datos a gran escala y recursos computacionales, por lo que es difícil implementarlas y experimentar con ellas directamente a través de ejemplos de aprendizaje. En su lugar, es recomendable obtener una comprensión conceptual a través de los artículos y documentos técnicos de cada modelo.

En la sección 10.3, examinamos diversas metodologías y estrategias teóricas para fusionar datos multimodales. A partir de esto, revisaremos técnicas específicas sobre cómo los modelos multimodales reales representan eficazmente la información de cada modalidad y aprenden las relaciones entre diferentes modalidades. La implementación completa se encuentra en chapter_10/multimodal_embeding.py.

Una de las tareas centrales del aprendizaje multimodal es cómo representar modalidades con características diferentes en un espacio común significativo. Las imágenes son arreglos bidimensionales de valores de píxeles, el texto es una secuencia unidimensional de tokens, y el audio es valores de amplitud a lo largo del tiempo; cada modalidad tiene su propia forma de representación única. Para procesar eficazmente estos datos heterogéneos, se necesita una técnica de aprendizaje de representaciones que mantenga las características intrínsecas de cada modalidad y capture sus relaciones semánticas.

Enfoque inicial: codificadores individuales + proyección

Los modelos multimodales iniciales utilizaban codificadores especializados para cada modalidad (por ejemplo, CNN para imágenes, RNN para texto) para extraer vectores de características, y luego los proyectaban a un espacio vectorial común mediante una transformación lineal o una MLP (Multi-Layer Perceptron) somera. (Consulte el método de Representación Conjunta, Concatenación en la sección 10.3.1)

Enfoque reciente: alineación semántica

Recientemente, se ha dado prioridad a un enfoque que va más allá del simple ajuste dimensional y busca que los vectores de características de cada modalidad estén “alineados” semanticamente entre sí. Es decir, las imágenes relacionadas y el texto deben estar cerca en el espacio de incrustación, mientras que las imágenes no relacionadas y el texto deben estar lejos.

Aprendizaje contrastivo: (Consulte la Representación Coordinada en la sección 10.3.2, ejemplo de CLIP) Se considera un par imagen-texto como una muestra “positiva” y un par imagen-texto mezclado aleatoriamente como una muestra “negativa”, y se aprende aumentando la similitud entre las muestras positivas y disminuyendo la similitud entre las muestras negativas.

Pérdida de tripletas: Se usan tres elementos: una imagen ancla, un texto positivo (el caption correspondiente a la imagen) y un texto negativo (el caption de otra imagen), para aprender que la distancia entre la imagen ancla y el texto positivo sea cercana, mientras que la distancia entre la imagen ancla y el texto negativo sea lejana.

Ejemplo de implementación (Aprendizaje contrastivo)

class MultimodalEmbedding(nn.Module):

def __init__(self, embedding_dim=512):

super().__init__()

self.image_encoder = models.resnet18(pretrained=True)

self.image_encoder.fc = nn.Sequential(

nn.Linear(512, embedding_dim),

nn.LayerNorm(embedding_dim)

)

self.text_encoder = BertModel.from_pretrained('bert-base-uncased')

self.text_projection = nn.Sequential(

nn.Linear(768, embedding_dim), # BERT output dimension is 768

nn.LayerNorm(embedding_dim)

)

self.logit_scale = nn.Parameter(torch.ones([]) * np.log(1 / 0.07))

def encode_image(self, image):

return self.image_encoder(image)

def encode_text(self, input_ids, attention_mask):

text_features = self.text_encoder(input_ids, attention_mask)[0][:, 0, :] # [CLS] token, keep batch dim

return self.text_projection(text_features)MultimodalEmbedding clase:

image_encoder: Utiliza ResNet18 para convertir imágenes en vectores de características de tamaño embedding_dim.text_encoder: Utiliza el modelo BERT para convertir texto en vectores de características y ajustarlos a un tamaño embedding_dim mediante la capa text_projection.logit_scale: Es un parámetro de temperatura aprendible utilizado en CLIP.Mecanismo de alineación semántica

La alineación semántica se implementa principalmente en las siguientes dos partes: el método forward de la clase MultimodalEmbedding y constrasive_loss().

def forward(self, image, input_ids, attention_mask):

image_features = self.encode_image(image)

text_features = self.encode_text(input_ids, attention_mask)

image_features = image_features / image_features.norm(dim=-1, keepdim=True)

text_features = text_features / text_features.norm(dim=-1, keepdim=True)

logit_scale = self.logit_scale.exp()

logits = logit_scale * image_features @ text_features.transpose(-1, -2)

# print("logits:", logits.shape)

return logits # Return a single valueforward método:

Usa encode_image y encode_text para codificar las imágenes y el texto, respectivamente.

Normalización de características (Feature Normalization): Ajusta la magnitud de los vectores image_features y text_features a 1 mediante normalización L2 (L2 normalization). Esto se hace para considerar solo la dirección del vector al calcular la similitud.

Escalado de temperatura (Temperature Scaling): Ajusta la distribución de las puntuaciones de similitud utilizando logit_scale. Se aplica el valor logit_scale a una función exponencial para obtener un factor de escala, que luego se multiplica por el producto matricial del tensor de características de imagen y el tensor de características de texto transpuesto. El producto matricial calcula los productos internos (dot products) entre cada vector de características de imagen y todos los vectores de características de texto para generar las puntuaciones de similitud.

logits: Calcula la similitud (productos internos) entre los vectores de características de imagen y los vectores de características de texto. Se utiliza text_features.transpose(-1, -2) en lugar de text_features.t() para realizar la transposición. Esto intercambia las dos últimas dimensiones del tensor de características de texto, cambiando su forma de (lote, dimensión de características de texto) a (lote, dimensión de características, texto), lo que permite multiplicarlo con el tensor de características de imagen de forma (lote, dimensión de características de imagen).

def contrastive_loss(logits): # removed enhanced_similarity

labels = torch.arange(logits.size(0), device=logits.device) # Use logits.size(0)

# Image-to-text and text-to-image contrastive loss

img_txt_loss = nn.CrossEntropyLoss()(logits, labels)

txt_img_loss = nn.CrossEntropyLoss()(logits.T, labels)

# Average loss

return (img_txt_loss + txt_img_loss) / 2La función contrastive_loss genera labels como enteros desde 0 hasta (tamaño del lote - 1) para ajustarse al tamaño de la matriz logits. Los elementos diagonales (i, i) en la matriz logits representan la similitud entre la i-ésima imagen y el i-ésimo texto. Es decir, estas entradas diagonales representan la similitud del par positivo (imagen y texto correspondientes), por lo que se configuran las etiquetas para que estos elementos diagonales sean los correctos. Además, img_txt_loss calcula la pérdida de similitud de imagen a texto (image-to-text loss), mientras que txt_img_loss calcula la pérdida de similitud de texto a imagen (text-to-image loss). Al promediar estas dos pérdidas, se tiene en cuenta el alineamiento semántico bidireccional (de imagen a texto y de texto a imagen).

El mecanismo de alineamiento semántico mapea las características de diferentes modalidades a un espacio semánticamente coherente. Primero, se proyectan todos los vectores de características a una esfera unitaria mediante la normalización L2 para eliminar las diferencias de escala entre las modalidades. Se introduce un parámetro de escalado de temperatura para ajustar la distribución de valores de similitud. Una alta temperatura produce una distribución más suave, mientras que una baja temperatura genera una distribución más aguda, lo cual mejora la estabilidad del aprendizaje. Además, a través del aprendizaje contrastivo, se entrena para que las parejas imagen-texto relacionadas estén cercanas y las no relacionadas estén lejanas en el espacio de incrustación. En particular, se optimiza simultáneamente el mapeo de imagen a texto y de texto a imagen para lograr un alineamiento semántico bidireccional.

Al igual que en el aprendizaje contrastivo de CLIP, los contenidos relacionados se aprenden a estar cercanos y los no relacionados lejanos. Esta estrategia de alineamiento semántico basada en aprendizaje contrastivo ha evolucionado desde la introducción del CLIP por OpenAI en 2021 hasta el PaLM-E de Google, el Claude de Anthropic y el Gemini de DeepMind. Mientras que el CLIP inicial se centraba principalmente en el aprendizaje contrastivo simple de pares imagen-texto, los modelos más recientes capturan relaciones intermodales con mayor sofisticación. En particular, Gemini aprende simultáneamente el alineamiento semántico entre diferentes modalidades como imágenes, texto, audio y video, construyendo un espacio de significado integrado que preserva las características únicas de cada modalidad.

Ejemplo de ejecución

Se utiliza el conjunto de datos flicker8k para el entrenamiento. Se puede utilizar la función train_multimodal_embedding para entrenar el modelo EnhancedMultimodalEmbedding (o EnhancedMultimodalEmbedding_no_p) con el conjunto de datos Flickr8k. En la función main, se configuran el modelo, el cargador de datos, el optimizador, etc., y al llamar a la función train_multimodal_embedding, comienza el entrenamiento.

# download flickr8k.

!mkdir data;cd data;wget "https://github.com/awsaf49/flickr-dataset/releases/download/v1.0/flickr8k.zip";unzip -q flickr8k.zip -d ./flickr8kmkdir: cannot create directory ‘data’: File exists

--2025-03-09 16:33:12-- https://github.com/awsaf49/flickr-dataset/releases/download/v1.0/flickr8k.zip

Resolving github.com (github.com)... 20.200.245.247

Connecting to github.com (github.com)|20.200.245.247|:443... connected.

HTTP request sent, awaiting response... 302 Found

Location: https://objects.githubusercontent.com/github-production-release-asset-2e65be/753516996/d7c62b13-1e50-40ea-8fae-f34a44b1695f?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=releaseassetproduction%2F20250309%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20250309T073156Z&X-Amz-Expires=300&X-Amz-Signature=ff62cf7df8ac3deba8bd6f4f775e164abf03c6d2d6d86d740e5407e52702c6a3&X-Amz-SignedHeaders=host&response-content-disposition=attachment%3B%20filename%3Dflickr8k.zip&response-content-type=application%2Foctet-stream [following]

--2025-03-09 16:33:12-- https://objects.githubusercontent.com/github-production-release-asset-2e65be/753516996/d7c62b13-1e50-40ea-8fae-f34a44b1695f?X-Amz-Algorithm=AWS4-HMAC-SHA256&X-Amz-Credential=releaseassetproduction%2F20250309%2Fus-east-1%2Fs3%2Faws4_request&X-Amz-Date=20250309T073156Z&X-Amz-Expires=300&X-Amz-Signature=ff62cf7df8ac3deba8bd6f4f775e164abf03c6d2d6d86d740e5407e52702c6a3&X-Amz-SignedHeaders=host&response-content-disposition=attachment%3B%20filename%3Dflickr8k.zip&response-content-type=application%2Foctet-stream

Resolving objects.githubusercontent.com (objects.githubusercontent.com)... 185.199.109.133, 185.199.111.133, 185.199.110.133, ...

Connecting to objects.githubusercontent.com (objects.githubusercontent.com)|185.199.109.133|:443... connected.

HTTP request sent, awaiting response... 200 OK

Length: 1112971163 (1.0G) [application/octet-stream]

Saving to: ‘flickr8k.zip’

flickr8k.zip 100%[===================>] 1.04G 56.8MB/s in 19s

2025-03-09 16:33:32 (56.9 MB/s) - ‘flickr8k.zip’ saved [1112971163/1112971163]

import torch

from torchvision import models, transforms

from torch.utils.data import Dataset, DataLoader

# Assuming dldna.chapter_10.multimodal_embedding is in the same directory or Python path.

# Adjust if necessary (e.g., from multimodal_embedding import ...).

from dldna.chapter_10.multimodal_embedding import Flickr8kDataset, MultimodalEmbedding, train_multimodal_embedding, generate_example

# Data transformation setup

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

# Dataset and DataLoader setup

image_dir = './data/flickr8k/Images' # Replace with the actual path to your image directory

caption_file = './data/flickr8k/captions.txt' # Replace with the actual path to your caption file

dataset = Flickr8kDataset(image_dir, caption_file, transform=transform)

train_size = int(0.8 * len(dataset))

val_size = len(dataset) - train_size

train_dataset, val_dataset = torch.utils.data.random_split(dataset, [train_size, val_size])

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True, num_workers=4)

val_loader = DataLoader(val_dataset, batch_size=32, shuffle=False, num_workers=4)

# Model initialization

model = MultimodalEmbedding()

# Model training

train_multimodal_embedding(model, train_loader, val_loader, num_epochs=3)

# Model saving

torch.save(model.state_dict(), 'multimodal_embedding_model.pth')

# Example generation

model_path = 'multimodal_embedding_model.pth'

generate_example(model_path, image_dir, caption_file)Epoch 1/3: 15%|█▍ | 147/1012 [00:16<01:36, 8.96it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 1/3: 100%|██████████| 1012/1012 [01:53<00:00, 8.90it/s]Epoch 1/3 - Train Loss: 0.9618Epoch 1/3 - Validation Loss: 0.5212

Epoch 1: Saved best model with Validation Loss = 0.5212Epoch 2/3: 52%|█████▏ | 525/1012 [00:59<00:55, 8.84it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 2/3: 100%|██████████| 1012/1012 [01:54<00:00, 8.83it/s]Epoch 2/3 - Train Loss: 0.3393Epoch 2/3 - Validation Loss: 0.4240

Epoch 2: Saved best model with Validation Loss = 0.4240Epoch 3/3: 34%|███▍ | 347/1012 [00:39<01:15, 8.85it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 3/3: 100%|██████████| 1012/1012 [01:54<00:00, 8.83it/s]Epoch 3/3 - Train Loss: 0.2313Epoch 3/3 - Validation Loss: 0.3891

Epoch 3: Saved best model with Validation Loss = 0.3891

Image 0:

Top 3 Captions (Image -> Text):

- football players in red congratulate each other as crowds in red cheer behind. (prob: 0.9970)

- a man in black holds up an obama 08 sign. (prob: 0.0023)

- a large group of bicycles racing on the street (prob: 0.0004)

Caption: football players in red congratulate each other as crowds in red cheer behind.

Top 3 Images (Text -> Image):

- Image 0 (prob: 0.9983)

- Image 17 (prob: 0.0013)

- Image 2 (prob: 0.0001)

La atención cruzada modal se utiliza para modelar eficazmente las relaciones entre diferentes modalidades. Esto extiende la autoatención del ViT, permitiendo la interacción entre datos heterogéneos como imágenes y texto.

Diseño de atención entre modalidades

La atención cruzada modal tiene una estructura asimétrica que considera las características de cada modalidad.

class CrossModalAttention(nn.Module):

def __init__(self, config):

super().__init__()

self.image_proj = nn.Linear(config.image_dim, config.hidden_dim)

self.text_proj = nn.Linear(config.text_dim, config.hidden_dim)

self.attention = nn.MultiheadAttention(config.hidden_dim, config.num_heads)

def forward(self, image_features, text_features):

image_proj = self.image_proj(image_features)

text_proj = self.text_proj(text_features)

attn_output, _ = self.attention(text_proj, image_proj, image_proj)

return attn_outputProyecta las características de imagen y texto a un espacio latente común, luego aprende la relación entre las dos modalidades mediante el mecanismo de atención multi-cabezal. Las características del texto se utilizan como consulta, mientras que las características de la imagen se usan como clave y valor para que el texto preste atención a las partes relevantes de la imagen.

Patrón de atención asimétrica

Se utiliza un patrón de atención asimétrico para preservar las características únicas de cada modalidad mientras se logra un intercambio de información efectivo.

class HierarchicalCrossModalAttention(nn.Module):

def __init__(self, config):

super().__init__()

self.local_image_attention = nn.MultiheadAttention(config.hidden_dim, config.num_heads)

self.local_text_attention = nn.MultiheadAttention(config.hidden_dim, config.num_heads)

self.image_to_text_attention = CrossModalAttention(config)

self.text_to_image_attention = CrossModalAttention(config)

self.output_layer = nn.Linear(config.hidden_dim * 2, config.hidden_dim)

def forward(self, image_features, text_features):

local_image = self.local_image_attention(image_features, image_features, image_features)[0]

local_text = self.local_text_attention(text_features, text_features, text_features)[0]

image_attended_text = self.image_to_text_attention(image_features, local_text)

text_attended_image = self.text_to_image_attention(text_features, local_image)

combined_features = torch.cat([image_attended_text, text_attended_image], dim=-1)

output = self.output_layer(combined_features)

return outputAquí se realizan atenciones bidireccionales por separado, de texto a imagen e imagen a texto. Esto permite que cada modalidad pueda centrarse selectivamente en la información relevante de la otra modalidad.

Estructura de atención jerárquica

Para capturar relaciones multimodales complejas, se organizan varias capas de atención de manera jerárquica. En las capas inferiores, se procesan características locales dentro de cada modalidad, mientras que en las capas superiores se modelan las relaciones globales entre modalidades. Esta estructura jerárquica desempeña un papel clave en modelos como GPT-4V y Gemini.

class EnhancedMultimodalEmbedding_no_p(MultimodalEmbedding):

def forward(self, image, input_ids, attention_mask):

image_features = self.encode_image(image)

text_features = self.encode_text(input_ids, attention_mask)

image_features = self.image_preserve(image_features)

text_features = self.text_preserve(text_features)

combined_features = self.cross_modal_attention(image_features, text_features)

combined_features = combined_features / combined_features.norm(dim=-1, keepdim=True)

logit_scale = self.logit_scale.exp()

logits = logit_scale * combined_features @ combined_features.t()

return logitsimport torch

from torchvision import models, transforms

from torch.utils.data import Dataset, DataLoader

from collections import namedtuple

from dldna.chapter_10.crossmodal_attention import Flickr8kDataset, CrossModalEmbedding, train_crossmodal_embedding, generate_example

# Configuration

config = namedtuple('Config', ['embedding_dim', 'image_dim', 'text_dim', 'hidden_dim', 'num_heads'])(

embedding_dim=512, # Output embedding dimension

image_dim=512, # ResNet18 image encoder output dimension

text_dim=512, # Text feature (768 from BERT -> 512 after projection)

hidden_dim=512, # Cross-modal attention internal hidden dimension

num_heads=8 # Number of multi-head attention heads

)

# Data transformation setup

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

# Dataset and DataLoader setup

image_dir = './data/flickr8k/Images' # Change to the actual path

caption_file = './data/flickr8k/captions.txt' # Change to the actual path

dataset = Flickr8kDataset(image_dir, caption_file, transform=transform)

train_size = int(0.8 * len(dataset))

val_size = len(dataset) - train_size

train_dataset, val_dataset = torch.utils.data.random_split(dataset, [train_size, val_size])

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True, num_workers=4, pin_memory=True)

val_loader = DataLoader(val_dataset, batch_size=32, shuffle=False, num_workers=4, pin_memory=True)

# Model initialization

model = CrossModalEmbedding(config)

# Model training

train_crossmodal_embedding(model, train_loader, val_loader, num_epochs=3)

# Model saving

torch.save(model.state_dict(), 'crossmodal_embedding_model.pth')Epoch 1/3: 4%|▍ | 40/1012 [00:04<01:41, 9.53it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 1/3: 100%|██████████| 1012/1012 [01:47<00:00, 9.41it/s]Epoch 1/3 - Train Loss: 0.9663Epoch 1/3 - Validation Loss: 0.5378Epoch 2/3: 58%|█████▊ | 582/1012 [01:02<00:45, 9.36it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 2/3: 100%|██████████| 1012/1012 [01:48<00:00, 9.31it/s]Epoch 2/3 - Train Loss: 0.3381Epoch 2/3 - Validation Loss: 0.4452Epoch 3/3: 0%| | 4/1012 [00:00<02:27, 6.82it/s]Image file not found: ./data/flickr8k/Images/imageEpoch 3/3: 100%|██████████| 1012/1012 [01:48<00:00, 9.35it/s]Epoch 3/3 - Train Loss: 0.2288Epoch 3/3 - Validation Loss: 0.3743# Example generation

model_path = 'crossmodal_embedding_model.pth'

generate_example(model_path, image_dir, caption_file)Image 0:

Top 3 Captions (Image -> Text):

- two people walk out onto the desert sand. (prob: 0.9862)

- a man takes a picture of him and his friend with his phone. (prob: 0.0092)

- the little boy wearing the blue shirt is putting dirt in his mouth. (prob: 0.0013)

Caption: two people walk out onto the desert sand.

Top 3 Images (Text -> Image):

- Image 0 (prob: 0.9898)

- Image 2 (prob: 0.0089)

- Image 4 (prob: 0.0005)